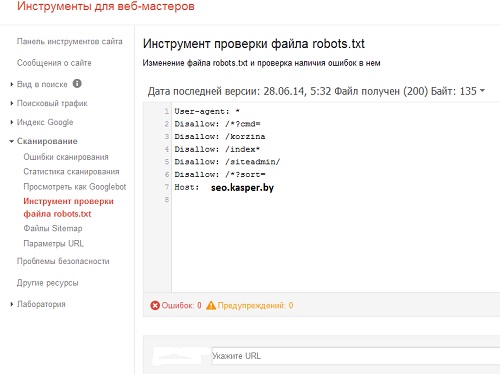

Google обновил фитчу проверки файла robots.txt в инструментах для вебмастера. Новый robots.txt работает в разделе «Сканирование» , его просто найти в левом меню в личном кабинете вебмастера.

Новая тузла легко справляется с проблемой поиска прописанных директив, которые блокируют конкретные URL-ы в массивных файлах robots.txt.

Специалисты компании Google советуют производить повторную проверку файла robots.txt, применяя собственные инструменты сервиса Webmaster Tools:

например, функцию "Посмотреть как Google сканирует сайт" в разделе «Сканирование» (Crawl), это позволяет вебмастеру смотреть страницы сайта, содержащие изображения, файлы CSS и JavaScript.

Предупреждение: если Googlebot обнаружит внутреннюю ошибку сервера 500, появляющуюся при изменении файла robots.txt, Google автоматом прекратит сканирование вашего сайта.