Санкции в seo: фильтры Google

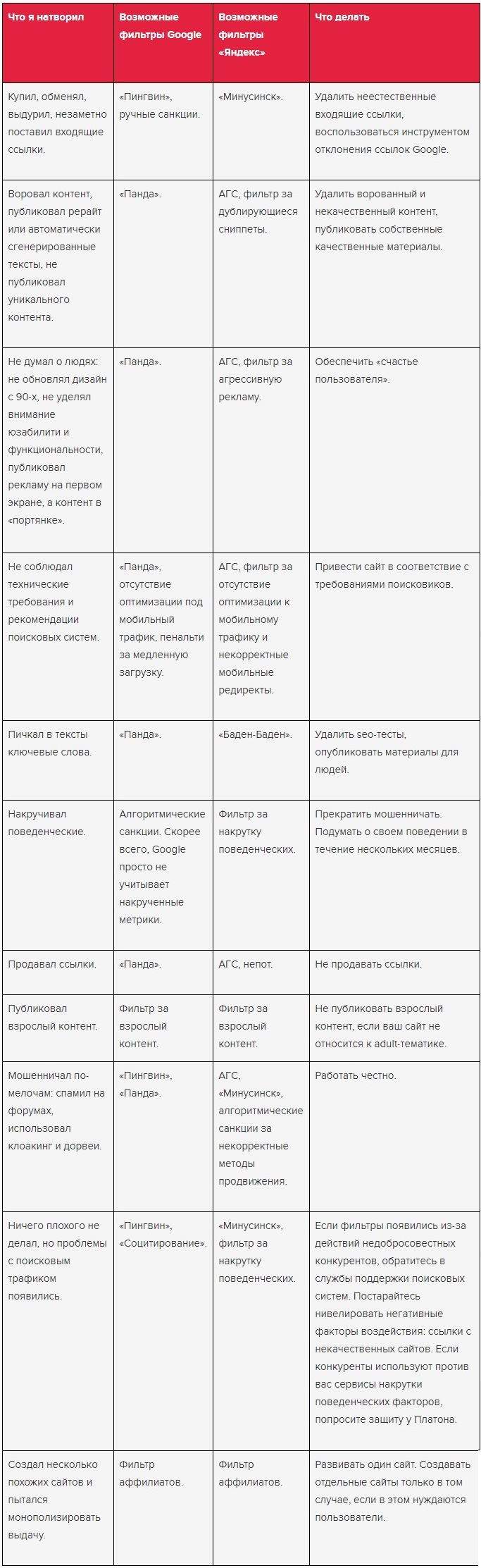

Гугл стал первым поисковиком, кто начал фильтровать проекты по самым различным критериям. Цель -понижение позиций некачественных ресурсов. Искусственно влияние на поисковую выдачу, применение различные ухищрений, недоработки поисковых алгоритмов – это приводит к довольно строгим мерам.

Чтобы бороться с подобными манипуляциями, для вебмастеров были разработаны особые рекомендации по оптимизации. В них указываются запрещенные методы продвижения. Использование нечестных способов оптимизации контролируется, наказывается наложением поисковых санкций – фильтров.

Большинство санкций можно разбить на две группы: фильтры, применяемые за внутренние факторы ранжирования и за внешние.

Фильтры Гугл за внутренние нарушения

Florida – один из самых первых фильтров Google, который направлен против внутренней переоптимизации. Florida применялся к ресурсам со слишком большой плотностью ключевых слов в тексте или заголовке. Злоупотребление выделением слов курсивом или жирным так же наказывается. В результате санкций происходит заметное понижение позиций.

Впервые Флорида был введен в 2003 году и с тех пор он несколько раз видоизменялся. На сегодняшний день действует менее жесткая версия алгоритма.

Для того чтобы снять действие алгоритма достаточно убрать элементы агрессивной оптимизации.

Sandbox («Песочница»), этот алгоритм применяется к новым сайтам, у которых нет нужного доверия со стороны поисковой системы. Google Sandbox не позволяет молодому сайту (около 2-3 месяцев) занимать высокие позиции по продвигаемым запросам.

С «Песочницей» сталкивается каждый новый проект. Основная задача: на определенном этапе доказать поисковику, что ресурс действительно качественный. Для этого необходимо развивать проект, наполнять его качественным контентом, регулярно закупать немного ссылок с тематических страниц.

Too many pages at once Filter – фильтр, под который попадают сайты за слишком большое количество добавленной информации. Если на блоге появилось сразу много новых страниц, то специальные алгоритмы Google могут посчитать, что происходит автоматическое наполнение контента. Это очень часто применяют недобросовестные оптимизаторы в черных методах продвижения.

Чтобы не попасть под санкции за резкое увеличение контента, не следует одновременного добавлять большое число страниц. Делать это лучше регулярно, но постепенно, небольшими объемами. Также не стоит забывать и про уникальность текстов.

Supplemental Results – этот алгоритм находит страницы с похожим контентом и переводит их в дополнительный поиск. Ресурсы, попавшие под фильтр, будут показаны, если в основном результате будет слишком мало сайтов.

Чтобы избежать Google Supplemental Results, нужно удалить идентичный контент или разместить новый уникальный текст, мета-теги. Если он уже был применен, то после того, как информация была переписана, рекомендуется закупить на страницы немного внешних ссылок.

Omitted Results – данный программный продукт переносит страницы со схожим контентом в дополнительные результаты поиска. Блоги, попавшие под его действие, можно увидеть, если нажать в поиске кнопку «повторить поиск, включив опущенные результаты».

Чтобы избавится от действия Google Omitted Results следует удалить все дубли страниц , переписать неуникальный текст.

Broken Link Filter – накладывается на сайт в том случае, если на нем обнаруживается большое количество битых ссылок. Сбивка внутренней перелинковки страниц может произойти, если на проекте часто меняются адреса страниц. Если выполнен редизайн или меню отсылает на несуществующие страницы, санкции так же налаживаются. Доверие к ресурсу со стороны поисковика падает, и он понижает позиции в результатах поиска.

При помощи специальных программ следует выполнять проверку сайта на наличие битых ссылок и вовремя избавляться от них.

С появлением нового алгоритма ранжирования Google Caffeine, появился Page Load Time Filter, который борится со слишком долгой загрузкой страниц. Этот фильтр призывает вебмастера обращать внимание на скорость загрузки, нужно стараться ее уменьшать.

Duplicate Content – это поисковая программа анализирует дублирование контента. Ресурс, к которому был применен данный фильтр, перестает реагировать на любые действия по его продвижению.

Основное правило, которым следует руководствоваться, чтобы не попасть под действие Google Duplicate Content – заполнять все уникальным текстом. Если у вас не слишком высокие показатели Page Rank, то рекомендуется защищать контент от копирования при помощи специальных скриптов, чтобы избежать ошибочного наложения фильтра.

Panda – самый новый на сегодня понижающий алгоритм, который принимает во внимание около 100 факторов. Главная задача Google Panda увеличить релевантность страниц в выдаче.

Чтобы не попасть под его действие необходимо проводить полноценный комплекс работ по продвижению и улучшению значительного количества параметров оценки ресурса.

Фильтры Гугл за внешние нарушения

Google - 30 накладывается на сайты, которые были заподозрены в использовании запрещенных, «черных» методов продвижения (клоакинг, дорвеи, редиректы и др.). Проект сначала понижается в выдаче на 30 позиций. В случае, если нарушения не были устранены, то сайт будет полностью исключен из индекса.

После прекращения использования запрещенных методов продвижения, действие алго снимается, но если домен исключили из индекса, то придется обратиться в службу технической поддержки.

Google Bombing – накладывается, если есть много внешних ссылок с одинаковыми анкорами. При этом фильтр значительно снижает вес, который передают внешние ссылки.

Для снятия Google Bombing необходимо разбавить анкор-лист поставленных ссылок. Рекомендуется снять часть link и докупить новых, с большим разнообразием анковров. Также следует увеличить число «естественных» анкоров: тут, здесь и т.п.

Co-Citation Filter – санкции накладывают за наличие «плохих» ссылок на сайт, т.е. с сайтов запрещенных тематик.

Поэтому перед покупкой тщательно проверяйте донор на тематичность и наличие сомнительных ссылок.

To Many Links at Once Filter – понижающий фильтр за резкий прирост внешних ссылок. Часто под него попадают молодые ресурсы, когда в короткий срок покупается большое количество ссылочной массы.

Чтобы не попасть под To Many Links at Once Filter наращивать ссылочную массу нужно постепенно и максимально естественным образом. Для молодых сайтов рекомендуется закупать не более 3-7 качественных ссылок в день, а уже при дальнейшем продвижении темпы можно увеличить.

Знание основных санкций поисковых систем важно при работе оптимизаторов. Оно позволяет грамотно планировать стратегию комплексного продвижения без использования запрещенных методов раскрутки.

О фильтрах Яндекса можно прочитать тут.